-

大语言模型仍无法可靠区分信念与事实

2025-11-07 08:33:23 来源:

(资料图)

(资料图)

财联社11月7日电,在最新一期《自然·机器智能》发表的一篇论文中,美国斯坦福大学研究提醒:大语言模型(LLM)在识别用户错误信念方面存在明显局限性,仍无法可靠区分信念还是事实。研究表明,当用户的个人信念与客观事实发生冲突时,LLM往往难以可靠地作出准确判断。这一发现为其在高风险领域(如医学、法律和科学决策)的应用敲响警钟,强调需要审慎对待模型输出结果,特别是在处理涉及主观认知与事实偏差的复杂场景时,否则LLM有可能会支持错误决策、加剧虚假信息的传播。

大语言模型(LLM) 资料图

免责声明:本网站所有信息,并不代表本站赞同其观点和对其真实性负责,投资者据此操作,风险请自担。

上一篇: 【ETF动向】11月6日建信上证科创板综合ETF基金涨2.17%|快看

下一篇:最后一页

相关阅读

精彩推送

-

IGG(00799.HK)11月4日耗资53.71万港元回...

格隆汇11月4日丨IGG(00799 HK)发布公告,2025年11月4日耗资53 71万港元

2025-11-04 17:15:49

要闻

-

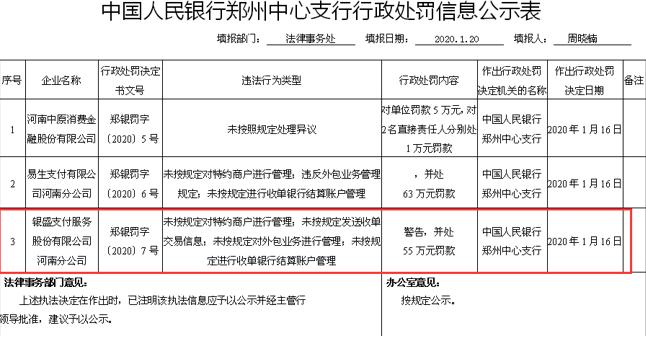

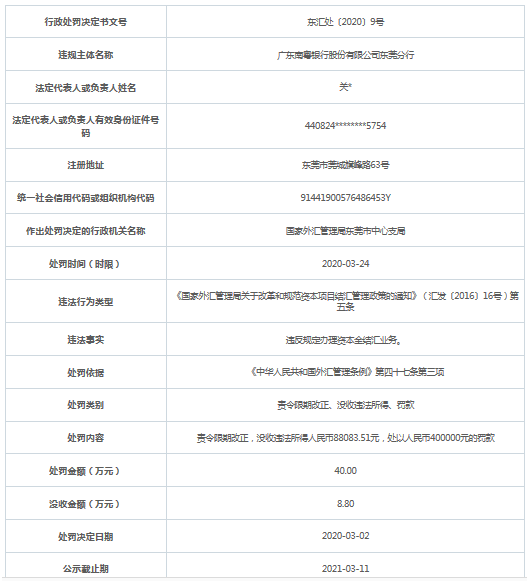

南粤银行东莞分行违法领罚单 违规办理资本金结汇业务

2020-03-12 国家外汇管理局广东省分局近日公布的行政处罚信息公示表(东汇处〔2020〕9号)显示,广东南粤银行股份有限公司...

-

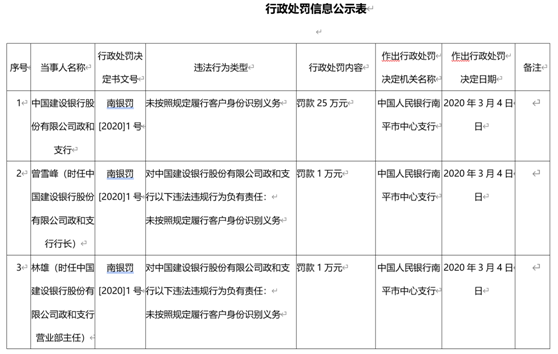

建设银行福州一支行违法领罚单 未按照规定识别客户身份

2020-03-12 中国人民银行福州中心支行今日公布的行政处罚信息公示表(南银罚[2020]1号)显示,中国建设银行股份有限公司政...

-

稠州银行陷助贷风波 出借人之谜 不良贷款率持续抬升

2020-03-12 《投资壹线》汪下弟近期,稠州银行可谓境遇不佳。除了屡次收到监管机构的罚单,还陷入助贷风波,涉及多起投...

- 联易融科技-W(09959.HK)连续35日回购,...

- 秋色宜人 带动文旅市场持续火热|焦点观察

- 实时焦点:路维光电:已实现180nm制程节...

- 和讯投顾陈炜:3500家上涨背后!或藏有...

- 祝贺!WTT1000+冠军榜孙颖莎王楚钦继续...

- 洽洽食品已回购177万股 金额4336万元|每日速看

- 赢家时尚(03709):受托人根据股份奖励计...

- 破发股中自科技董事拟减持 2021上市见...

- 今日热闻!金龙机电:公司股东人数在定期...

- 每日视讯:青岛高新区专精特新企业再迎扩...

- 莒南农商行“换帅”:彭善国任行长,6名...

- 高山企业(00616.HK):截至2025年10月31...

- 今日快看!教育家精神万里行|李志新:做...

- 美团发布LongCat-Flash-Omni:开启全模...

- 工商银行:11月3日起暂停受理部分如意金...

- 11月3日国内硝酸市场行情动态|每日快播

- 动态焦点:长亮科技:公司与腾讯主要在金...

- 简讯:中山公用:公司通过新能源产业基金...

- 媒体人:亚泰其他工作人员好久没发薪了...

- 肖战告黑粉侵权案件审理终结

- 焦点消息!粉笔盘初涨超8% AI刷题系统...

- 补齐制度拼图 公募业绩比较基准新规出...

- 【异动提醒】圣泉集团(605589)11月3日...

- 张奔斗:辛纳一边夺冠,一边升级 每日看点

- 奥特曼称OpenAI年收入远超130亿美元

- 险资“买买买” 持仓A股市值超6500亿元

- 森麒麟:公司董事会秘书已取得深圳证券...

- 中省媒体行·必须是孝感丨槐荫船说,夜...

- 关注:东吴证券:给予福斯特买入评级

- ST逸飞:签订约1.9亿元海外采购订单

- 赛力斯:10月新能源汽车销量同比增长42....

- 【时快讯】苏超冠军没想到是泰州队!牛

- 十五运会吉祥物“喜洋洋”“乐融融”大...

- 焦点快看:海南离岛免税新政首日 免税...

- “最北滑雪场”首滑 点燃今冬冰雪游 观点

- 要闻:跨度、难度、速度硬核破纪录!点...

- 全新宝马M3旅行版正式上市 售94.39万元

- 百度文小言5.0版本更名为文心

- 观天下!埃贝尔:即便大轮换,拜仁从第1...

- 美国哈佛医学院一建筑发生爆炸 疑似蓄...

- 讯息:我国明年将发射梦舟一号等4艘飞船...

- 播报:“苏超”决赛夜,南通第二观赛点超...

- 德甲前瞻|拜仁1-2勒沃库森:全胜今晚会...

- 焦点讯息:东契奇:詹姆斯如果复出,湖...

- 福美堂优选荣膺“百家推客机构”, 创...

- 中欧睿见混合A:2025年第三季度利润5636...

- 新华视点|沃野金秋收获忙 共绘丰年好图景

- 简讯:重2650吨桥面“坐电梯”升降 华中...

- 交割月空头交货流程怎样?-每日速讯

- 美国I Bond利率微升至4.03% 固定利率...

- 【聚看点】神舟二十一号航天员乘组顺利...

- 焦点精选!欧洲股市收盘下跌 但连续第...

- 空中成像概念龙头一览(2025/10/31)

- 神话世界(00582):供股获超额认购约3.69...

- 焦点信息:约战张本美和!王艺迪决胜时刻...

- 国家知识产权局印发《知识产权促进民营...

- 天天资讯:时空科技:公司主营业务未发生...

- 康隆达:股东计划减持不超过3%公司股份...

- 中意人寿:前三季度保险业务收入352.77...

- 观察:PriceSeek提醒:LME锌库存增加400吨

- 热议:邓紫棋武汉演唱会即将开唱 武汉公...

- 华纳兄弟探索(WBD.US)成并购香饽饽 获R...

- 热资讯!民生银行:预计四季度不良生成...

- 吉林省秋收进入收尾阶段 确保应收尽收_...

- 报喜鸟:公司主营业务为品牌服装的研发...

- 每日消息!航天员张陆即将二度出征太空,...

- 观天下!国家发展改革委:今年供暖季能...

- 每日速讯:生意社:上海期货交易所10月3...

- 10月31日抖音概念(字节概念)板块涨幅达2...

- 宇通重工前三季度实现营收23.91亿元 今日热讯

- 当前聚焦:长飞光纤光缆公布前三季度业...

- 视讯!深交所:深港通下的港股通标的调...

- 每日关注!广东肇庆通报“保洁横穿田径跑...

- 博瑞传播:融资净买入1174.94万元,融资...

- 高测股份获84家机构调研:公司硅片切割...

- 东北证券上调回天新材评级 热门

- 播报:亚马逊美股盘后涨超8%

- 二季度养老地产概念股毛利润TOP15排名:...

- 中信建投证券(06066.HK)第三季度净利润...

- 陈涛:伊万是高不可攀的大树,全力以赴...

- 人与自然和谐共生,650万尾鱼苗为河池水...

- 欧元区第三季度GDP环比增长0.2%

- 富维股份拟每10股派息1.4元|观热点

- 成队史首人,里夫斯绝杀后打趣:詹姆斯...

- 每日讯息!金融监管总局就《行政许可实施...

- 11月1日起,免税店政策“升级”!-焦点速看

- 金科环境:公司与ecooil签订设备供货合...

- “苏”然起敬|人工智能专家陈哲走进雨...

- “苏韵乡情”乡村休闲旅游农业(南京)...

- 2025年9月国家能源局核发绿证2.29亿个-...

- 阳光电源成立曜储检测技术公司-百事通

- 荣泰健康(603579)龙虎榜数据(10-30)

- 观察:高盛:百威亚太(01876)上季中国业...

- 世界黄金协会:三季度中国市场零售黄金...

- 快报:中超最辛苦10人:吴曦排第六,前五...

- 【焦点热闻】“戴眼镜”博导航天员再现...

- 培育钻石板块快速拉升,惠丰钻石涨超15%

- 创升控股午后涨超18% 中期股东应占溢利...

- 美银证券:升中海油田服务(02883)目标价...

- 焦点快看:中石科技第三季度归母净利润...